Cómo evoluciona el keyword research con la IA

SEO y LLM en 2026: metodología práctica y verificable para empresas

En 2026, el keyword research no desaparece: cambia de foco. La captura de demanda en Google sigue dependiendo de arquitectura, intención y señales clásicas de SEO, pero una parte creciente del descubrimiento ocurre en experiencias generativas (p. ej., AI Overviews) donde importa que tu contenido sea fácil de recuperar, entender y citar. Este artículo detalla un proceso integrado para:

- construir un universo de keywords comercialmente útil

- traducirlo a clusters por intención y entidades

- producir contenido 'citable' por motores generativos sin sacrificar performance en SEO tradicional.

El objetivo no es 'posicionar en un LLM' como si fuera un buscador clásico. El objetivo es maximizar probabilidad de inclusión (recuperación) y reutilización (síntesis) cumpliendo buenas prácticas públicas de buscadores y manteniendo precisión, fuentes y trazabilidad.

Qué ha cambiado (y qué no) desde el keyword research clásico

Lo que NO ha cambiado

• Google sigue necesitando rastreo, indexación y señales de calidad para rankear contenido.

• La intención y la demanda siguen siendo la base para priorizar contenido y landings.

• E-E-A-T/fiabilidad y políticas anti-spam siguen condicionando visibilidad.

Lo que SÍ ha cambiado

• La unidad práctica de optimización ya no es la keyword aislada, sino el 'concepto' expresado en frases declarativas.

• En experiencias generativas, el usuario puede obtener una síntesis antes del clic; por tanto, el contenido debe ser fácilmente 'resumible' sin perder precisión.

• Aparecen nuevos puntos de medición: presencia en AI Overviews/experiencias de IA, menciones/citas y consistencia semántica marca→tema.

Google publica guía específica sobre AI features (incluyendo AI Overviews/AI Mode) para propietarios de sitios y cómo enfocar tu contenido. [1] Además, sus recomendaciones de 'contenido útil y fiable' y políticas anti-spam siguen siendo el marco operativo.

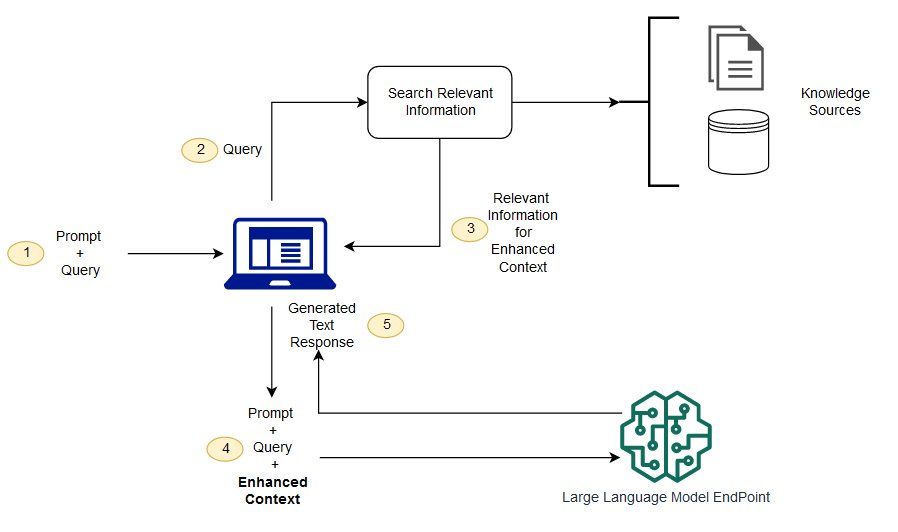

Cómo “leen” los motores generativos

Para keyword research orientado a LLM, necesitas una explicación mínima: muchos sistemas generativos combinan una fase de recuperación (recoger fuentes) con una fase de síntesis (redactar respuesta). Lo que suele funcionar mejor en recuperación y síntesis son contenidos con:

• definiciones claras y verificables

• estructura explícita (pasos, checklists, criterios)

• lenguaje estable (pocas ambigüedades)

• señales de fiabilidad (autoría, referencias, actualización, experiencia demostrable)

Google ha publicado recomendaciones para “tener éxito en la búsqueda con IA” y explica que AI Overviews muestra enlaces de distintas formas y abre oportunidades para propietarios de sitios. Microsoft, por su parte, ha reforzado la idea de respuestas con citas a fuentes, aumentando la importancia de ser una fuente clara y atribuible.

El proceso completo: keyword research integrado (SEO + LLM)

A continuación tienes un workflow replicable. Incluye entregables concretos y decisiones. El ejemplo de trabajo será una keyword competida del mercado de préstamos bancarios: “préstamos personales”.

Paso 0 — Definir el “concepto madre” y la hipótesis de posicionamiento

Antes de abrir herramientas, define una frase de posicionamiento que un LLM pueda reutilizar sin reinterpretar tu intención.

Ejemplo (préstamos):

Concepto definido:

“Ofrecemos préstamos bancarios diseñados para cubrir necesidades de financiación personal, con condiciones transparentes, evaluación responsable del riesgo y un proceso claro orientado a la toma de decisiones informadas.”

Entregable: 1–2 frases de posicionamiento + 3 bullets de diferenciación verificable (casos, marco, especialización sectorial).

Paso 1 — Captura de lenguaje humano (SERP intelligence)

Objetivo: documentar cómo el mercado formula la intención de búsqueda en productos de préstamos y qué subtemas aparecen en el top (títulos, subtítulos, PAA, búsquedas relacionadas).

Acción: crear una hoja de trabajo con columnas: Query, Intención (I / C / T / N), Subtema, Entidad financiera (préstamos, TIN, TAE, scoring, solvencia, normativa), Tipo de página observada (guía, landing de producto, simulador, comparador), Notas de ángulo.

ej:Tabla — SERP intelligence · Producto: Préstamos bancarios

| Query | Intención (I / C / T / N) | Subtema detectado | Entidad principal | Tipo de página observada | Notas de ángulo |

| préstamo personal | T / C | Producto core | Préstamos | Landing comercial | Captación directa, foco en condiciones y rapidez |

| préstamos personales banco | C | Comparativa por entidad | Préstamos | Landing / comparador | Marca + confianza, SEO muy competitivo |

| préstamo online banco | T | Canal digital | Préstamos | Landing comercial | Velocidad, proceso 100 % online |

| mejor préstamo personal | I / C | Comparativa | Préstamos | Artículo / comparador | SEO informacional con fuerte intención comercial |

| simulador préstamo personal | I / T | Cálculo financiero | Préstamos | Herramienta | Lead magnet, alta conversión |

| ... | ... | ... | Préstamos | ... | ... |

Paso 2 — Captura de lenguaje “LLM” (phrasing extraction)

Objetivo

Extraer phrasing recurrente (frases y patrones) que los modelos de lenguaje utilizan para explicar productos de préstamos, especialmente en contextos de banca y financiación, y que son reutilizables en respuestas generativas.

Prompts sugeridos

• “Define los préstamos personales bancarios en 2 frases para un CMO.”

• “Explica el proceso de concesión de un préstamo bancario en 7 pasos claros.”

• “Qué KPIs miden el éxito de un producto de préstamos y cómo los reporta un banco.”

• “Errores comunes en la comercialización de préstamos bancarios y señales de mala estructuración del producto.”

- Qué guardar

Definiciones claras y declarativas del producto (qué es, para quién, en qué casos se usa). - Listas de criterios recurrentes: tipo de interés, TAE, plazo, riesgo, scoring, elegibilidad, vinculación.

- Términos y patrones repetidos por los modelos: tipo de interés, plazo, capacidad de pago, riesgo crediticio, scoring, coste total, transparencia, condiciones claras.

- Frases orientadas a decisión: “evaluación de solvencia”, “financiación adaptada”, “condiciones personalizadas”, “cumplimiento regulatorio”.

Entregable: glosario de 30–80 términos/frases (no solo keywords) + 10–20 preguntas FAQ de alta intención decisora.

ej.

¿Qué banco ofrece el préstamo personal más adecuado según mi perfil financiero

¿Qué factores utiliza un banco para aprobar o rechazar un préstamo

¿Qué diferencia real hay entre TIN y TAE en un préstamo bancario

¿Cuánto puedo pedir en un préstamo personal según mis ingresos

¿Qué documentación exige un banco para conceder un préstamo

¿Es mejor un préstamo con o sin vinculación bancaria

¿Qué riesgos asume el cliente al contratar un préstamo a largo plazo

¿Cómo afecta un préstamo a mi scoring o historial crediticio

¿Cuándo conviene reunificar deudas mediante un préstamo

¿Qué diferencia hay entre un préstamo bancario y un crédito al consumo

¿Qué condiciones hacen que un préstamo sea considerado competitivo hoy

¿Cómo elegir entre varias ofertas de préstamos sin caer en sobreendeudamiento

Paso 3 — Expandir el universo de keywords (herramientas SEO, pero con filtros)

Con seeds por cluster (no una sola seed), expande en herramientas y elimina ruido no accionable.

Seeds ejemplo (préstamos):

• préstamos personales

• préstamo personal bancario

• financiación personal

• crédito al consumo

Filtros de negocio recomendados para targets senior:

• incluir: banco, entidad financiera, condiciones, simulador, financiación, requisitos, comparativa, coste, TAE, riesgo

• excluir: trabajos, pdf gratis, definición escolar, actividades para niños, curso gratuito (salvo que sea intencional)

Estas FAQ, deben ser predictivas, no describen solo búsquedas actuales, sino que anticipan:

- el momento previo a la decisión

- el lenguaje que usan los usuarios cuando ya van a contratar

- el tipo de preguntas que los LLM generan y reutilizan cuando alguien pide asesoramiento financiero

Paso 4 — Clusterización dual: por intención y por entidades

En 2026, clusterizar solo por intención es insuficiente en verticales complejos. Debes clusterizar también por entidades (conceptos/estándares) para construir autoridad semántica.

Ejemplos de entidades en banca: préstamos personales, crédito al consumo, hipotecas, TIN, TAE, scoring crediticio, riesgo, solvencia, normativa bancaria, protección del consumidor.

Tabla 1 — Roles de términos en un sistema SEO + LLM

| Rol | Qué resuelve | Ejemplos (banca / préstamos) |

| CORE (identidad) | Qué eres / qué vendes | préstamos personales, financiación bancaria, crédito al consumo |

CAPACIDAD | Qué sabes hacer (módulos) | simulador de préstamos, análisis de solvencia, scoring crediticio, cálculo TAE |

| CONTEXTO LLM | Cómo lo explica un modelo | marco de financiación, evaluación de riesgo, capacidad de pago, condiciones personalizadas |

| NEGOCIO | Por qué contratar (outcomes) | acceso a financiación responsable, previsibilidad de costes, reducción de riesgo crediticio, toma de decisiones informada |

Paso 5 — Arquitectura: mapear clusters a URLs sin canibalización

Regla práctica: 1 URL por intención principal. Separa money pages (servicio) de pillar posts (guía).

Ejemplo (préstamos bancarios):

/prestamos-personales/ (pilar, informacional decisor)

/prestamo-personal-banco/ (servicio, transaccional)

/simulador-prestamos/ (satélite funcional / CAPACIDAD)

/tae-tin-prestamos/ (satélite explicativo / CONTEXTO)

/requisitos-prestamo-bancario/ (satélite informacional)

/reunificacion-deudas-prestamo/ (satélite de caso de uso / NEGOCIO)

Paso 6 — Outline “citable” (estructura que funciona para SEO y síntesis)

Estructura recomendada para un pilar:

1) Definición en 2–3 líneas (declarativa)

2) Para quién es (segmentación)

3) Framework por pasos (5–9 pasos)

4) KPIs por etapa

5) Errores comunes

6) Checklist descargable/resumible

7) FAQ (PAA + preguntas extraídas de LLM)

8) Referencias/estándares (cuando aplique)

Tabla 2 — Framework operativo (ejemplo: Préstamos bancarios)

| Etapa | Objetivo | Entidades / inputs | Outputs “citables” |

| Diagnóstico | Definir perfil financiero y riesgo | ingresos, endeudamiento, scoring crediticio, normativa bancaria | perfil de solvencia, nivel de riesgo |

| Elegibilidad | Determinar viabilidad del préstamo | capacidad de pago, ratio endeudamiento, historial crediticio | criterios de elegibilidad |

| Condiciones | Convertir a variables medibles | TIN, TAE, plazo, importe, comisiones | condiciones del préstamo + KPIs |

| Estructuración | Definir oferta y responsabilidades | vinculación bancaria, productos asociados, política de riesgos | estructura del préstamo |

| Concesión | Ejecutar la financiación | evaluación interna, aprobación, contrato | importe concedido, calendario |

| Seguimiento | Medir y controlar el préstamo | cuotas, amortización, cumplimiento | estado del préstamo, métricas |

| Iteración | Ajustar y optimizar | renegociación, refinanciación, feedback cliente | mejoras, nuevas condiciones |

Esta tabla muestra cómo estructurar el contenido sobre préstamos para que tanto Google como los sistemas generativos comprendan el producto de forma completa. Cada etapa refleja el razonamiento real del decisor y organiza las entidades financieras clave (riesgo, TAE, solvencia) en outputs claros y reutilizables. El objetivo no es describir el proceso interno del banco, sino construir autoridad semántica y generar contenido fácilmente citable en búsquedas tradicionales y experiencias de IA.

KPIs y medición (lo que un Head of Growth debe exigir)

KPIs SEO clásicos (siguen siendo obligatorios)

• Visibilidad por cluster (no solo por keyword): impresiones, CTR y share por tema.

• Ranking por intención (servicio vs guía) y canibalización.

• Cobertura de indexación, Core Web Vitals, enlazado interno y rastreo.

• Calidad editorial: actualización, autoría, referencias, señales de confianza.

Google enfatiza contenido útil y fiable y mantiene políticas para reducir contenido spam/no original. [2][5]

KPIs para experiencias generativas (proxies realistas)

No existe una métrica universal única para “visibilidad en LLM” por ahora. En la práctica, se usan proxies:

• Presencia en AI Overviews para un set fijo de queries (muestreo y tracking periódico)

• Aparición como fuente enlazada/citada cuando el producto muestra citas

• Consistencia del “cómo te describe” el sistema (marca→tema→atributos)

• Tráfico referencial desde motores generativos (cuando exista)

KPIs de negocio (lo único que importa en boardroom)

- Solicitudes cualificadas de préstamo (leads aptos) atribuibles o influenciadas por tráfico orgánico y/o experiencias de IA.

- Ratio de conversión en páginas de producto de préstamos (y su contribución al pipeline comercial del banco).

- CAC orgánico por préstamo concedido y payback estimado, según el modelo de atribución y el margen financiero del producto.

- Win-rate de préstamos aprobados en oportunidades donde orgánico o IA fue primer punto de contacto o canal asistente (CRM + autodeclarado).

Integración operativa: cómo combinar SEO y LLM sin duplicar trabajo

Un equipo que ejecuta bien en 2026 hace una sola investigación y produce dos outputs:

1) arquitectura SEO (clusters, URLs, interlinking)

2) paquetes de ‘answer assets’ para síntesis (definiciones, checklists, comparativas, FAQs)

Roles recomendados (estructura mínima)

• SEO Lead: arquitectura, clusterización, mapping, medición.

• Content Strategist: outlines, coherencia, intención decisora.

• SME (experto del dominio): precisión y ejemplos reales.

• Tech SEO: indexación, rendimiento, datos estructurados, logs.

• Growth/Analytics: KPIs, atribución y experimentación.

Cómo transmitir E-E-A-T sin autobombo

E-E-A-T no es un claim: es una combinación de señales verificables. Los criterios aparecen en las Search Quality Rater Guidelines y documentos explicativos.

Implementación práctica para un pilar:

• Autoría clara: quién escribe y por qué es competente (bio breve + experiencia relevante)

• Evidencias: casos, metodologías, ejemplos, métricas (sin revelar datos sensibles)

• Fuentes: estándares, guías oficiales, regulación, docs técnicos

• Actualización: fecha + changelog + revisión periódica

• Transparencia: qué sí sabemos, qué depende del contexto, límites de medición

Plantilla de “bio” (ejemplo)

Ejemplo:

"Diseñamos y gestionamos estrategias de contenidos y visibilidad orgánica para productos financieros, con especial foco en préstamos y financiación bancaria. Nuestro enfoque integra SEO, semántica y criterios de calidad alineados con la normativa y las guías oficiales, para ofrecer información clara, fiable y orientada a la toma de decisiones de nuestros clientes."

Checklist final

- Definir concepto madre + frase de posicionamiento verificable

- Capturar lenguaje humano: top 10, PAA, related, snippets

- Capturar lenguaje IA: definiciones, frameworks, KPIs, errores

- Expandir universo en herramienta SEO con filtros de intención decisora

- Clusterizar por intención y por entidades

- Mapear clusters a URLs (servicio vs pilar) sin canibalización

- Diseñar outline citable: definición, pasos, KPIs, errores, checklist, FAQ

- Añadir señales E-E-A-T: autoría, evidencias, fuentes, actualización

- Medir: SEO (GSC) + proxies generativos + negocio (pipeline)

- Iterar cada 4–8 semanas con tests controlados

FAQ

¿Sigue siendo útil el keyword research clásico?

Sí. Sigue siendo necesario para priorizar demanda y mapear arquitectura SEO. Lo nuevo es añadir una capa de conceptos y phrasing para síntesis generativa.

¿Puedo “posicionar” en un LLM igual que en Google?

No de la misma forma. En experiencias generativas intervienen recuperación y síntesis. Puedes aumentar probabilidad de inclusión con claridad, estructura y fiabilidad.

¿Qué debo medir si quiero visibilidad en AI Overviews?

Presencia por query set, citas/enlaces cuando existan, consistencia de asociación marca→tema y tráfico referencial (si aparece).

¿Qué tipo de contenido suele ser más citable?

Definiciones claras, frameworks por pasos, checklists, comparativas y explicaciones con términos estables y referencias.

Referencias (fuentes de alta autoridad)

[Google Search Central — AI features and your website (AI Overviews/AI Mode): developers.google.com/search/docs/appearance/ai-features

Google Search Central — Creating helpful, reliable, people-first content: developers.google.com/search/docs/fundamentals/creating-helpful-content

Google Search Central Blog — Succeeding in AI Search (AI Overviews/AI Mode): developers.google.com/search/blog/2025/05/succeeding-in-ai-search

Microsoft Copilot Blog — Citations in Copilot (AI search experience): microsoft.com/microsoft-copilot/blog/2025/11/07/bringing-the-best-of-ai-search-to-copilot/

Google Blog — March 2024 spam policies & quality improvements: blog.google/products/search/google-search-update-march-2024/

[6] Google Search Quality Rater Guidelines (PDF, updates incl. 2025): guidelines.raterhub.com/searchqualityevaluatorguidelines.pdf

Google — Search Quality Rater Guidelines: An Overview (E-E-A-T): services.google.com/fh/files/misc/hsw-sqrg.pdf

Google Search Central — Guidance on using generative AI content: developers.google.com/search/docs/fundamentals/using-gen-ai-content

Sobre mi:

Trabajo en estrategia SEO avanzada y arquitectura de contenidos para empresas y sectores complejos, donde conviven buscadores tradicionales y experiencias de búsqueda generativa (LLM). Mi enfoque combina semántica, calidad editorial y medición real para construir autoridad, visibilidad y crecimiento sostenible en entornos altamente competitivos.