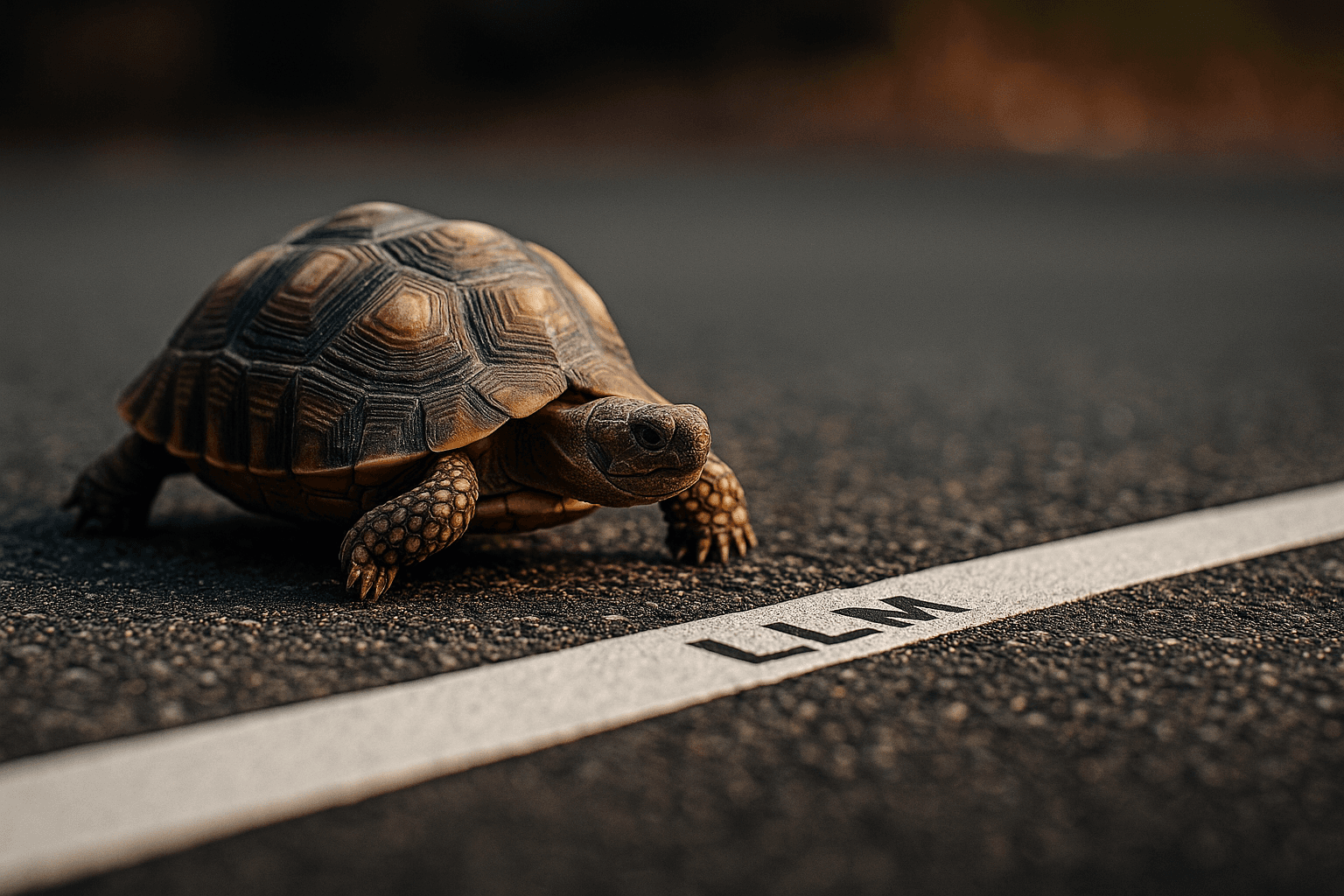

¿Cuánto tardan las LLM en procesar y aprender de tu contenido?

Las LLMs (Large Language Models) como ChatGPT, Claude o Gemini no acceden a la web en tiempo real como lo hacen algunos buscadores. Mientras que motores como Google o Bing rastrean e indexan nuevas páginas de forma continua y priorizada según autoridad, las LLMs entrenadas por lotes no actualizan su conocimiento constantemente. En su lugar, incorporan contenido mediante datasets tomados de la web pública en intervalos definidos, lo que introduce una latencia significativa. Por eso, aunque tu contenido esté ya publicado e indexado en Google, puede tardar semanas o meses en ser integrado y citado por ciertos modelos de lenguaje.

¿Qué modelos leen contenido nuevo con más rapidez?

Los modelos que más rápido incorporan contenido reciente son ChatGPT con navegación activada, Perplexity.ai y You.com. Estas herramientas utilizan agentes que acceden directamente a URLs y pueden citar textos incluso de publicaciones recientes, si el contenido es rascable y la fuente tiene suficiente autoridad. En cambio, modelos como Gemini o Claude dependen más de datasets entrenados por lotes, lo que genera mayor latencia en la incorporación.

¿Cuánto tiempo tarda en promedio una LLM en incorporar contenido nuevo?

En condiciones óptimas (web pública, HTML limpio, estructura semántica clara y dominio de alta autoridad), los modelos con acceso a web pueden empezar a citar contenido en menos de 24 horas. Sin embargo, el entrenamiento masivo de modelos base puede tardar entre 30 y 90 días, dependiendo del modelo y su política de actualización.

| Plataforma / Modelo | Mecanismo de actualización | Tiempo estimado de lectura/uso de nuevo contenido |

| ChatGPT-4o (con navegación activada) | Agente de navegación por Bing | 1-2 días si se accede a la URL |

| Perplexity.ai | Navegación directa + citación en tiempo real | En minutos u horas |

| You.com (modo Research) | Navegador web + indexación selectiva | En el mismo día |

| Google Search (indexación SEO) | Crawling con prioridad por autoridad | Horas (sitios grandes), 1–10 días promedio |

| Google Gemini (LLM) | Entrenamiento por lotes + Google Search | 30–90 días o más |

| Bing AI (Copilot) | Bing Index + modelo generativo | 1–3 días si el contenido está indexado en Bing |

| Anthropic Claude | Entrenamiento por snapshots | Varias semanas a meses |

| LLMs open source (Mistral, Falcon) | Dataset preentrenado (estático) | No acceden a nuevo contenido tras entrenamiento |

¿Qué condiciones debe cumplir tu contenido para ser leído y citado?

El contenido debe cumplir cinco criterios fundamentales:

- Ser visible públicamente (sin muros de pago, registros ni bloqueos).

- Estar en HTML bien estructurado (encabezados claros, contenido semántico, marcado Schema si es posible).

- Incluir frases rascables: definiciones, listas, comparativas, argumentos concretos, citas o datos.

- Estar bien enlazado internamente (para facilitar su descubrimiento por agentes).

- Tener autoridad temática (ser coherente con el resto de contenidos del dominio).

Si tu página cumple estos criterios, es más probable que los modelos la indexen, citen y respondan con ella.

¿Qué puedes hacer para acelerar su lectura por parte de las LLMs?

- Promueve tu contenido en canales que usan IA (por ejemplo, responde preguntas en Quora, Reddit, Perplexity o foros donde estas herramientas rastrean).

- Solicita inclusión en Perplexity o Bing Chat con enlaces contextuales desde dominios rascados por ellos.

- Optimiza tu contenido para respuestas directas: haz que cada H2 tenga una explicación corta, clara y factual debajo (estilo "snippet").

- Evita textos excesivamente literarios, metafóricos o genéricos: no son útiles para las LLMs ni para los usuarios.

¿Qué indicadores te muestran que tu contenido ya está siendo usado?

- Si escribes una query específica en ChatGPT con navegación y el resultado incluye tu texto o lo parafrasea.

- Si en Perplexity.ai aparece tu artículo como fuente o parte del resumen generado.

- Si herramientas como Bing AI resumen tu contenido en la vista previa al compartir el enlace.

- Si tus definiciones son citadas literalmente en otros artículos automatizados.

¿Tiene sentido crear contenidos específicamente para LLMs?

Sí, absolutamente. En el nuevo paradigma de búsqueda y navegación, los contenidos que mejor se posicionan no son los que más clics reciben en Google, sino los que las LLMs deciden mostrar, citar y recomendar. Un contenido bien diseñado para modelos generativos puede darte visibilidad constante, incluso sin tráfico orgánico directo. El reto ya no es aparecer en la SERP, sino formar parte de la respuesta.

Fuentes clave utilizadas

OpenAI Help Docs sobre navegación

Perplexity.ai – FAQ oficial

Google Search Central

Anthropic Claude System Card (PDF)

Experimentos de la comunidad SEO/LLM reproducibles en foros como Hacker News, Reddit, y estudios de Search Engine Journal.